Содержание

Этапы:

-

Потеря 94% трафика за вечер

-

Гипотезы провала

-

Ровно месяц спустя

-

Что же произошло

-

Ключевые уроки из кейса

Западный оптимизатор Гленн Гейб в блоге GSQi поделился историей, которая произошла с клиентским сайтом. Мы сделали адаптированный перевод.

Как составить бриф на SEO, рассказали в этом материале.

Потеря трафика и сильное понижение сайта в выдаче — страшная ситуация для компании, особенно если продажи преимущественно онлайн. Мы не можем контролировать Google: если что-то пойдет не так и рейтинг сайта упадет, компания потеряет деньги, пока веб-мастеры будут судорожно искать причину.

Потеря 94% трафика за вечер

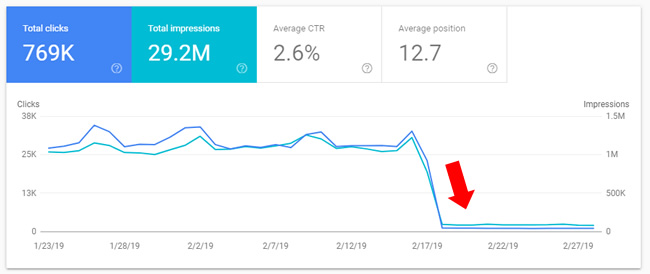

В среду 20 февраля Гленну написал его давний клиент с вопросом, известно ли ему о каких-то недавних апдейтах поисковика. Оказалось, что на днях их сайт заметно просел по позициям. 17 февраля в 18:00 органический трафик сайта из Google упал на 94%.

Падение трафика

Падение трафика

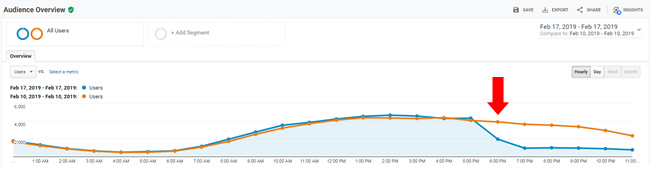

Падение трафика по часам

Падение трафика по часам

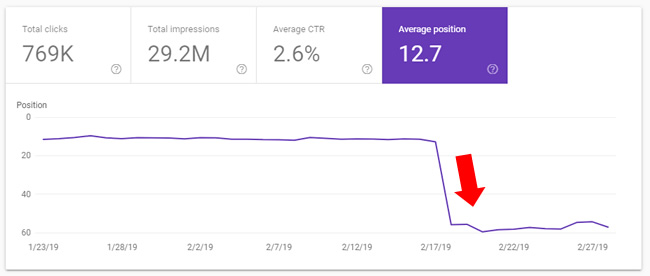

Падение средней позиции

Падение средней позиции

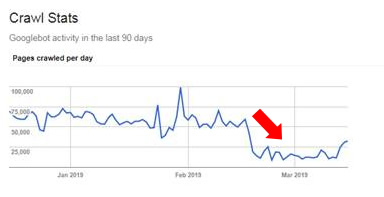

В момент, когда трафик и позиции упали, Google замедлил сканирование сайта.

Статистика сканирования из Google Search Console

Статистика сканирования из Google Search Console

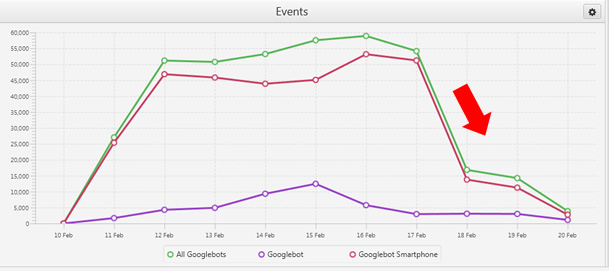

Также интересно посмотреть поведение Гуглбота — показатели сканирования упали.

Поведение Googlebot, скриншот из Screaming Frog Log Analyzer

Поведение Googlebot, скриншот из Screaming Frog Log Analyzer

Кроме того, упало сканирование и XML-карты сайта.

Итак, 17 февраля в 18:00 Google понизил сайт в выдаче, замедлил сканирование ресурса и почти перестал сканировать XML-карту. При этом большая часть трафика и доходов сайта поступала от Google. Разумеется, генеральный директор… немного волновался.

Гипотезы провала

Спад на 94% — худший показатель, который встречал специалист. Гленн Гейб начал искать причину такого падения.

Первые предположения: апдейт Google или хакеры

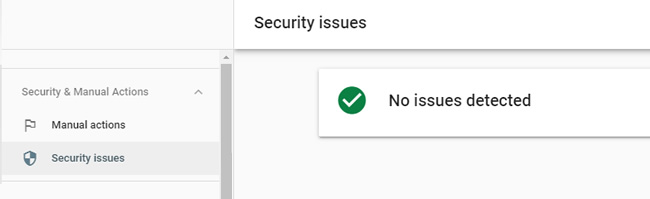

Две очевидные гипотезы: либо произошел апдейт Google, либо сайт атаковали хакеры или безопасность была нарушена как-то еще. Но в то воскресенье не было никакого серьезного обновления алгоритма, а в консоли Google не было предупреждений: ни «действий, выполняемых вручную», ни проблем с безопасностью.

В Google Search Console нет предупреждений

В Google Search Console нет предупреждений

Сайт работал многие годы, было очень странно потерять 94% за один день без влияния обновлений алгоритма или сбоя безопасности. Тем не менее, гипотезы пришлось отклонить.

Предположение второе: изменения на сайте

Раз дело не в сторонних причинах, нужно проанализировать внутренние. Директор рассказал, что в компании решили снова подключить форум, который когда-то был на сайте. Несколько лет назад форум находился на поддомене forum.domain.com, затем его переместили в подкаталог на поддомене www, еще когда поисковик внедрял алгоритм «Панда». Его закрыли из-за неактивности и некачественного контента много лет назад.

В пятницу активировали старый поддомен форума и начали настройку, а в воскресенье случился обвал. Во время падения трафика на поддомене форума еще не было контента, его только настраивали, но Google уже просканировал и проиндексировал несколько страниц.

Помимо форума, в последнее время на сайте не было никаких серьезных изменений, так что оптимизатор начал разбираться с поддоменом.

Что не так с поддоменом форума

Оптимизатор выяснил, что сам сайт использует Cloudflare и делится сертификатами IP и SSL примерно с 15 другими сайтами. Google всегда говорил, что обмен IP-адресами — это хорошо, и он не должен оказывать влияние на позиции сайта. Но бывали случаи, когда поисковик удалял сайты, которые делятся IP-адресами с некачественными сайтами мошенников или нарушителей. Есть и другие тематические исследования, которые выявили негативное влияние совместного использования IP-адресов через Cloudflare.

Субдомен отключили в среду 20 февраля, компания установила частный сертификат SSL и смогла получить другой IP-адрес. Все изменения были завершены 24 февраля.

Индексация качества

Google объяснил, что при оценке качества сайта учитывается каждая страница, поэтому важно убедиться, что индексируется только лучший контент. Оптимизатор советует доработать низкокачественный контент, вовсе удалить ненужный или не индексировать, если он должен оставаться на сайте.

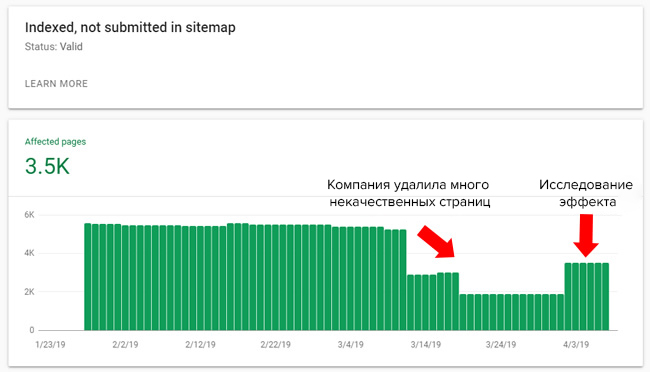

Гленн проанализировал информацию Google Search Console и данные сервисов DeepCrawl и Screaming Frog. При проверке проиндексированных страниц оказалось, что более половины не представлены в XML-файле Sitemap. Он сосредоточился на этих страницах и нашел в индексе тысячи URL низкого качества. Примерно 40-45% проиндексированных страниц — проблемные.

Это могло не быть причиной спада, но оптимизатор порекомендовал руководству разобраться с ситуацией. Они удалили большинство некачественных страниц.

Работа с некачественными страницами

Работа с некачественными страницами

После работы с гипотезами оставалось только ждать изменений со стороны поисковика. 12 марта Google выпустил обновление алгоритма, но никаких изменений не последовало. В течение месяца владелец сайта периодически присылал оптимизатору письма о том, что ничего не происходит, трафик на том же уровне.

Ровно месяц спустя

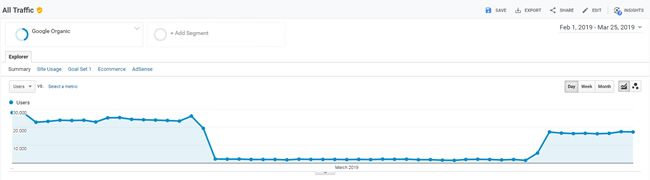

История началась с того, что 17 февраля ровно в 18:00 сайт потерял трафик и позиции. И ровно через месяц с точностью до часа позиции начали расти — 17 марта в 18:00 сайт вернулся к жизни!

Директор прислал электронное письмо со скриншотом аналитики, где виден всплеск. Тенденция сохранилась, показатели начали расти и вернулись примерно на тот же уровень.

Всплеск трафика

Всплеск трафика

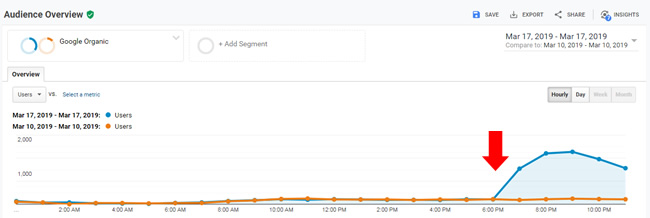

Почасовая аналитика показывает, что рост начался в шесть вечера — в то же время, что и спад месяц назад.

Почасовая аналитика

Почасовая аналитика

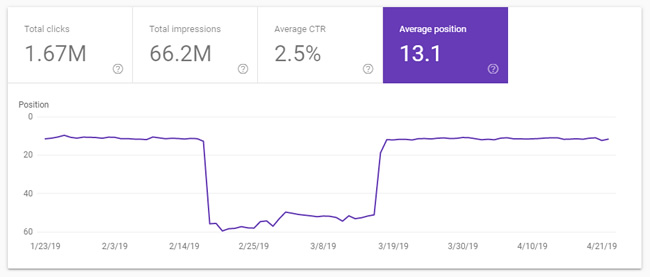

Клики и показы по данным Google Search Console начали восстанавливаться.

Произошел всплеск и по средней позиции.

Средняя позиция

Средняя позиция

В чем была причина: ежемесячное обновление алгоритма, выпадение сайта из индекса из-за проблем с безопасностью или что-то еще?

Что же произошло

Спад трафика и позиций может быть связан с восстановлением форума на поддомене, с некачественными страницами в индексе или с тем, что сайт делил IP-адреса с сомнительными сайтами. Возможно, причиной был какой-то алгоритм, который обновляется ежемесячно и в тот день распознал проблемы с безопасностью. Точную причину установить не получилось.

Оптимизатор склоняется к тому, что в большей степени виновата ситуация с форумом, которая вызвала проблему безопасности. Поисковик не прислал никаких уведомлений, так что оптимизатору оставалось искать причину, а владельцу сайта — переживать и искать пути компенсации потерь.

Ключевые уроки из кейса

Автор кейса советует всем веб-мастерам «не класть яйца в одну корзину» — если делать ставку на один поисковик и получать трафик только с него, неожиданные выпады из индекса и потери трафика могут нанести бизнесу непоправимый вред. У поисковика есть тысячи алгоритмов, которые могут сработать против сайта, и даже после нескольких лет работы можно потерять всё за один вечер. Для сайта из кейса таким вечером стало воскресенье 17 февраля.

Гленн Гейб составил вопросы, которые должен задать себе каждый владелец сайта. Лучше подумать о них сейчас, до того, как что-то пойдет не так.

7 важных вопросов для владельцев сайтов

- Какая часть вашего трафика и доходов зависит от Google?

- Как вы можете диверсифицировать свой трафик, чтобы снизить риск от потери позиций в Google?

- Если вы перестанете получать прибыль один-три месяца, полгода или дольше, как долго ваша компания сможет существовать? Как вы можете уменьшить риски?

- В вашей команде есть люди, которые могут справиться с катастрофической ситуацией в SEO? Это внешние или внутренние специалисты? Разработайте план по выходу из кризиса заранее.

- У вас есть система для тестирования изменений на сайте? Вы сможете понять причинно-следственную связь, если позиции упадут?

- Вы понимаете, что Google не идеален, и с сайтом могут происходить странные вещи? Вы готовы справляться с проблемами?

- Вы понимаете, что нет оснований рассчитывать на помощь команды Google, даже если сайт потеряет много трафика? Вы можете получить обратную связь, но Google не обязан консультировать владельцев бизнеса, если позиции упали из-за обновления алгоритма, ручных санкций, проблем безопасности и других.

Будьте готовы к «турбулентности» в SEO — никто не может контролировать поведение поисковика, поэтому стоит иметь запасной план на случай риска потерять всё.